Compare commits

No commits in common. "master" and "main" have entirely different histories.

|

|

@ -1,165 +0,0 @@

|

|||

# Byte-compiled / optimized / DLL files

|

||||

__pycache__/

|

||||

*.py[cod]

|

||||

*$py.class

|

||||

|

||||

# C extensions

|

||||

*.so

|

||||

|

||||

# Distribution / packaging

|

||||

.Python

|

||||

build/

|

||||

develop-eggs/

|

||||

dist/

|

||||

downloads/

|

||||

eggs/

|

||||

.eggs/

|

||||

lib/

|

||||

lib64/

|

||||

parts/

|

||||

sdist/

|

||||

var/

|

||||

wheels/

|

||||

pip-wheel-metadata/

|

||||

share/python-wheels/

|

||||

*.egg-info/

|

||||

.installed.cfg

|

||||

*.egg

|

||||

MANIFEST

|

||||

|

||||

# PyInstaller

|

||||

# Usually these files are written by a python script from a template

|

||||

# before PyInstaller builds the exe, so as to inject date/other infos into it.

|

||||

*.manifest

|

||||

*.spec

|

||||

|

||||

# Installer logs

|

||||

pip-log.txt

|

||||

pip-delete-this-directory.txt

|

||||

|

||||

# Unit test / coverage reports

|

||||

htmlcov/

|

||||

.tox/

|

||||

.nox/

|

||||

.coverage

|

||||

.coverage.*

|

||||

.cache

|

||||

nosetests.xml

|

||||

coverage.xml

|

||||

*.cover

|

||||

*.py,cover

|

||||

.hypothesis/

|

||||

.pytest_cache/

|

||||

|

||||

# Translations

|

||||

*.mo

|

||||

*.pot

|

||||

|

||||

# Django stuff:

|

||||

*.log

|

||||

local_settings.py

|

||||

db.sqlite3

|

||||

db.sqlite3-journal

|

||||

|

||||

# Flask stuff:

|

||||

instance/

|

||||

.webassets-cache

|

||||

|

||||

# Scrapy stuff:

|

||||

.scrapy

|

||||

|

||||

# Sphinx documentation

|

||||

docs/_build/

|

||||

|

||||

# PyBuilder

|

||||

target/

|

||||

|

||||

# Jupyter Notebook

|

||||

.ipynb_checkpoints

|

||||

|

||||

# IPython

|

||||

profile_default/

|

||||

ipython_config.py

|

||||

|

||||

# Profiling

|

||||

*.pclprof

|

||||

|

||||

# pyenv

|

||||

.python-version

|

||||

|

||||

# pipenv

|

||||

# According to pypa/pipenv#598, it is recommended to include Pipfile.lock in version control.

|

||||

# However, in case of collaboration, if having platform-specific dependencies or dependencies

|

||||

# having no cross-platform support, pipenv may install dependencies that don't work, or not

|

||||

# install all needed dependencies.

|

||||

#Pipfile.lock

|

||||

|

||||

# PEP 582; used by e.g. github.com/David-OConnor/pyflow

|

||||

__pypackages__/

|

||||

|

||||

# Celery stuff

|

||||

celerybeat-schedule

|

||||

celerybeat.pid

|

||||

|

||||

# SageMath parsed files

|

||||

*.sage.py

|

||||

|

||||

# Environments

|

||||

.env

|

||||

.venv

|

||||

.idea

|

||||

env/

|

||||

venv/

|

||||

ENV/

|

||||

env.bak/

|

||||

venv.bak/

|

||||

|

||||

# Spyder project settings

|

||||

.spyderproject

|

||||

.spyproject

|

||||

|

||||

# VSCode project settings

|

||||

.vscode/

|

||||

|

||||

# Rope project settings

|

||||

.ropeproject

|

||||

|

||||

# mkdocs documentation

|

||||

/site

|

||||

mkdocs_github_authors.yaml

|

||||

|

||||

# mypy

|

||||

.mypy_cache/

|

||||

.dmypy.json

|

||||

dmypy.json

|

||||

|

||||

# Pyre type checker

|

||||

.pyre/

|

||||

|

||||

# datasets and projects

|

||||

datasets/

|

||||

runs/

|

||||

wandb/

|

||||

tests/

|

||||

.DS_Store

|

||||

|

||||

# Neural Network weights -----------------------------------------------------------------------------------------------

|

||||

weights/

|

||||

*.weights

|

||||

*.pt

|

||||

*.pb

|

||||

*.onnx

|

||||

*.engine

|

||||

*.mlmodel

|

||||

*.mlpackage

|

||||

*.torchscript

|

||||

*.tflite

|

||||

*.h5

|

||||

*_saved_model/

|

||||

*_web_model/

|

||||

*_openvino_model/

|

||||

*_paddle_model/

|

||||

pnnx*

|

||||

|

||||

# Autogenerated files for tests

|

||||

/ultralytics/assets/

|

||||

|

|

@ -1,89 +0,0 @@

|

|||

# Ultralytics YOLO 🚀, AGPL-3.0 license

|

||||

# Pre-commit hooks. For more information see https://github.com/pre-commit/pre-commit-hooks/blob/main/README.md

|

||||

# Optionally remove from local hooks with 'rm .git/hooks/pre-commit'

|

||||

|

||||

# Define bot property if installed via https://github.com/marketplace/pre-commit-ci

|

||||

ci:

|

||||

autofix_prs: true

|

||||

autoupdate_commit_msg: '[pre-commit.ci] pre-commit suggestions'

|

||||

autoupdate_schedule: monthly

|

||||

submodules: true

|

||||

|

||||

# Exclude directories (optional)

|

||||

# exclude: 'docs/'

|

||||

|

||||

# Define repos to run

|

||||

repos:

|

||||

- repo: https://github.com/pre-commit/pre-commit-hooks

|

||||

rev: v4.5.0

|

||||

hooks:

|

||||

- id: end-of-file-fixer

|

||||

- id: trailing-whitespace

|

||||

- id: check-case-conflict

|

||||

# - id: check-yaml

|

||||

- id: check-docstring-first

|

||||

- id: double-quote-string-fixer

|

||||

- id: detect-private-key

|

||||

|

||||

- repo: https://github.com/asottile/pyupgrade

|

||||

rev: v3.15.0

|

||||

hooks:

|

||||

- id: pyupgrade

|

||||

name: Upgrade code

|

||||

|

||||

- repo: https://github.com/PyCQA/isort

|

||||

rev: 5.12.0

|

||||

hooks:

|

||||

- id: isort

|

||||

name: Sort imports

|

||||

|

||||

- repo: https://github.com/google/yapf

|

||||

rev: v0.40.2

|

||||

hooks:

|

||||

- id: yapf

|

||||

name: YAPF formatting

|

||||

|

||||

- repo: https://github.com/executablebooks/mdformat

|

||||

rev: 0.7.17

|

||||

hooks:

|

||||

- id: mdformat

|

||||

name: MD formatting

|

||||

additional_dependencies:

|

||||

- mdformat-gfm

|

||||

- mdformat-black

|

||||

exclude: 'docs/.*\.md'

|

||||

# exclude: "README.md|README.zh-CN.md|CONTRIBUTING.md"

|

||||

|

||||

- repo: https://github.com/PyCQA/flake8

|

||||

rev: 6.1.0

|

||||

hooks:

|

||||

- id: flake8

|

||||

name: PEP8

|

||||

|

||||

- repo: https://github.com/codespell-project/codespell

|

||||

rev: v2.2.6

|

||||

hooks:

|

||||

- id: codespell

|

||||

exclude: 'docs/de|docs/fr|docs/pt|docs/es|docs/mkdocs_de.yml'

|

||||

args:

|

||||

- --ignore-words-list=crate,nd,strack,dota,ane,segway,fo,gool,winn

|

||||

|

||||

- repo: https://github.com/PyCQA/docformatter

|

||||

rev: v1.7.5

|

||||

hooks:

|

||||

- id: docformatter

|

||||

|

||||

# - repo: https://github.com/asottile/yesqa

|

||||

# rev: v1.4.0

|

||||

# hooks:

|

||||

# - id: yesqa

|

||||

|

||||

# - repo: https://github.com/asottile/dead

|

||||

# rev: v1.5.0

|

||||

# hooks:

|

||||

# - id: dead

|

||||

|

||||

# - repo: https://github.com/ultralytics/pre-commit

|

||||

# rev: bd60a414f80a53fb8f593d3bfed4701fc47e4b23

|

||||

# hooks:

|

||||

# - id: capitalize-comments

|

||||

20

CITATION.cff

20

CITATION.cff

|

|

@ -1,20 +0,0 @@

|

|||

cff-version: 1.2.0

|

||||

preferred-citation:

|

||||

type: software

|

||||

message: If you use this software, please cite it as below.

|

||||

authors:

|

||||

- family-names: Jocher

|

||||

given-names: Glenn

|

||||

orcid: "https://orcid.org/0000-0001-5950-6979"

|

||||

- family-names: Chaurasia

|

||||

given-names: Ayush

|

||||

orcid: "https://orcid.org/0000-0002-7603-6750"

|

||||

- family-names: Qiu

|

||||

given-names: Jing

|

||||

orcid: "https://orcid.org/0000-0003-3783-7069"

|

||||

title: "YOLO by Ultralytics"

|

||||

version: 8.0.0

|

||||

# doi: 10.5281/zenodo.3908559 # TODO

|

||||

date-released: 2023-1-10

|

||||

license: AGPL-3.0

|

||||

url: "https://github.com/ultralytics/ultralytics"

|

||||

|

|

@ -1,8 +0,0 @@

|

|||

include *.md

|

||||

include requirements.txt

|

||||

include LICENSE

|

||||

include setup.py

|

||||

include ultralytics/assets/bus.jpg

|

||||

include ultralytics/assets/zidane.jpg

|

||||

include tests/*.py

|

||||

recursive-include ultralytics *.yaml

|

||||

76

README.md

76

README.md

|

|

@ -1,68 +1,8 @@

|

|||

# Sleeping-post-detection

|

||||

|

||||

# 睡岗检测

|

||||

|

||||

## 场景

|

||||

|

||||

本项目适用于一些需要持续工作的岗位或者某些重要的岗位,防止工作人员出现意外

|

||||

|

||||

## 介绍

|

||||

|

||||

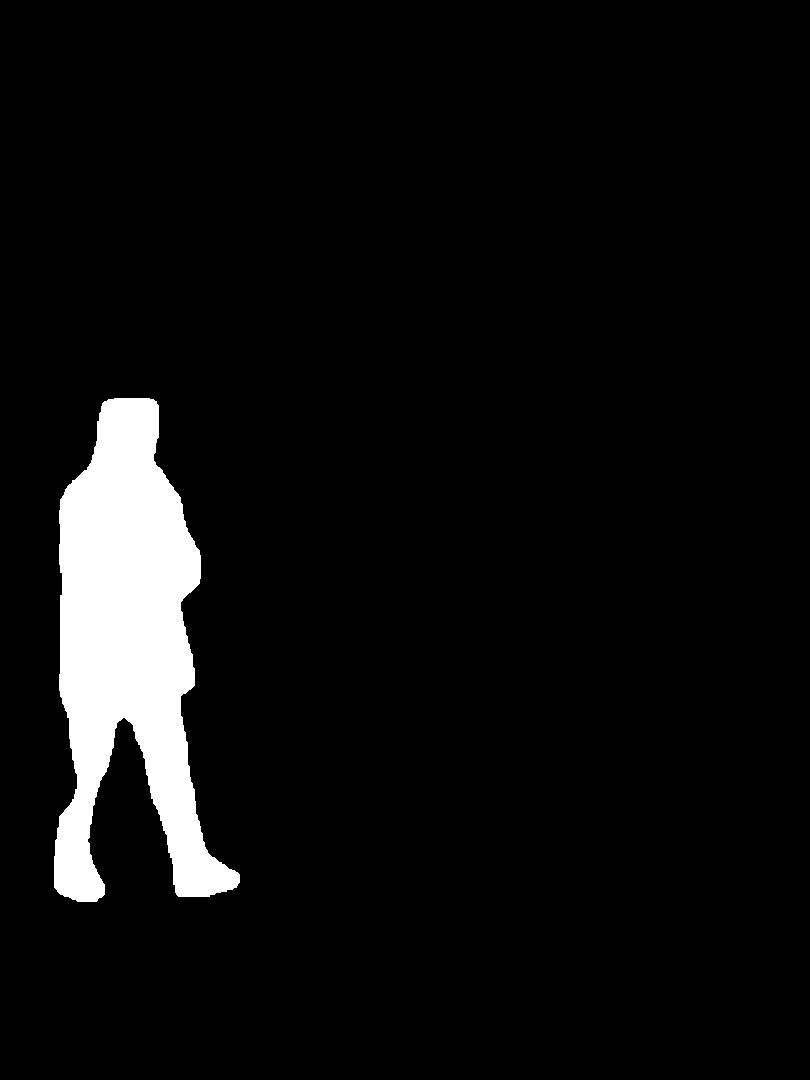

本项目是基于yolov8模型制作的睡岗检测

|

||||

|

||||

## 代码思路

|

||||

|

||||

1.为人头描定数据框,并且设置中心点

|

||||

|

||||

2.只要中心点在一定时间内,一定范围内运动,或者保持不动,便判定为睡岗

|

||||

|

||||

|

||||

## 使用说明:

|

||||

|

||||

### 注意:在使用前要确认环境已经搭配好了

|

||||

|

||||

### 1.需要安装依赖(我一般使用conda安装)

|

||||

|

||||

`conda install --yes --file requirements.txt`

|

||||

|

||||

### 2.需要安装opencv库

|

||||

|

||||

`conda install -c conda-forge opencv`

|

||||

|

||||

### 3.大部分需要安装的库都可以在pycharm中直接下载(如有遗漏)

|

||||

|

||||

### 4.指定训练好的模型进行测试

|

||||

|

||||

`model_path = r'\detect\train\weights\best.pt'` # 加载训练好的模型

|

||||

|

||||

`model = YOLO(model_path) ` # model是加载后的训练模型实例

|

||||

|

||||

### 5.进行静态检测的时候我们要注意我们当前代码仅支持 .png, .jpg, .jpeg, .bmp 等常见图像格式

|

||||

|

||||

### 6.phototest文件不仅支持单张图片检测并且支持批量检测(或文件夹检测),只需要按照下面代码指定文件夹即可

|

||||

|

||||

`infer_and_draw(r'C:\path\to\your\image\folder', r'C:\ultralytics\output')`

|

||||

|

||||

### 7.以下是对动态检测的一些代码讲解

|

||||

|

||||

#### 7.1 视频输入:

|

||||

|

||||

使用 cv2.VideoCapture() 打开视频文件或 RTSP 流,同时支持本地视频文件和网络串流

|

||||

|

||||

#### 7.2 YOLO 检测:

|

||||

|

||||

每隔 `detection_interval = 10` 帧,模型会对帧进行目标检测,返回检测到的边界框(boxes)和置信度(confidences)。

|

||||

检测的边界框经过过滤和合并后保存,并且通过 cv2.TrackerKCF_create() 创建跟踪器来跟踪每个目标。

|

||||

|

||||

#### 7.3 状态检测:

|

||||

|

||||

通过历史跟踪中心位置(center_history),每个物体的中心点会被记录到一个 deque(长度为 tracking_window_size = 250)。如果该物体的中心点在一段时间内变化很小,程序会在图像上显示“睡眠”(SLEEP),表明物体处于静止状态。

|

||||

通过计算中心点的距离变化(稳定状态的判断),判断物体是否保持静止。

|

||||

|

||||

### 运行方法(以下文件均在Sleeping-post-detection-first-edition目录下)

|

||||

|

||||

phototest文件夹专门负责检测图片

|

||||

|

||||

fps01 ~ fps04 文件夹代表了测试视频和实时检测时所犯的错误和更正过程,fps04为最终优化版本

|

||||

|

||||

|

||||

# Sleeping-post-detection-first-edition

|

||||

|

||||

Sleeping-post-detection

|

||||

睡岗检测

|

||||

主要场景

|

||||

睡岗检测一般应用于需要连续值守的场所

|

||||

介绍

|

||||

本项目主要是使用yolov8来完成人头检测的

|

||||

|

|

|

|||

17

ceshi.py

17

ceshi.py

|

|

@ -1,17 +0,0 @@

|

|||

#测试训练集

|

||||

|

||||

from ultralytics import YOLO

|

||||

|

||||

# 创建 YOLOv8 模型实例,选择适合的配置文件

|

||||

model = YOLO('yolov8n.yaml') # YOLOv8 Nano 配置文件(这个是从官网上下载的预训练模型)

|

||||

|

||||

# 配置训练参数

|

||||

model.train(

|

||||

data='data.yaml', # 数据配置文件

|

||||

epochs=150, # 训练轮数

|

||||

batch=8, # 批量大小(适合 CPU 计算)

|

||||

imgsz=320, # 图像尺寸(较小尺寸适合 CPU)

|

||||

device='cpu' # 训练设备设置为 CPU(本人用的是cpu)

|

||||

)

|

||||

|

||||

|

||||

|

|

@ -1,8 +0,0 @@

|

|||

|

||||

train: # 训练集路径

|

||||

val: # 验证集路径(如果训练集和验证集相同的话,这样写是可以的)

|

||||

|

||||

|

||||

nc: # 类别数

|

||||

|

||||

names: ['xxxx',‘xxxx’] # 类别名称

|

||||

|

|

@ -1,82 +0,0 @@

|

|||

# Ultralytics YOLO 🚀, AGPL-3.0 license

|

||||

# Builds ultralytics/ultralytics:latest image on DockerHub https://hub.docker.com/r/ultralytics/ultralytics

|

||||

# Image is CUDA-optimized for YOLOv8 single/multi-GPU training and inference

|

||||

|

||||

# Start FROM PyTorch image https://hub.docker.com/r/pytorch/pytorch or nvcr.io/nvidia/pytorch:23.03-py3

|

||||

FROM pytorch/pytorch:2.1.0-cuda12.1-cudnn8-runtime

|

||||

RUN pip install --no-cache nvidia-tensorrt --index-url https://pypi.ngc.nvidia.com

|

||||

|

||||

# Downloads to user config dir

|

||||

ADD https://ultralytics.com/assets/Arial.ttf https://ultralytics.com/assets/Arial.Unicode.ttf /root/.config/Ultralytics/

|

||||

|

||||

# Install linux packages

|

||||

# g++ required to build 'tflite_support' and 'lap' packages, libusb-1.0-0 required for 'tflite_support' package

|

||||

RUN apt update \

|

||||

&& apt install --no-install-recommends -y gcc git zip curl htop libgl1 libglib2.0-0 libpython3-dev gnupg g++ libusb-1.0-0

|

||||

|

||||

# Security updates

|

||||

# https://security.snyk.io/vuln/SNYK-UBUNTU1804-OPENSSL-3314796

|

||||

RUN apt upgrade --no-install-recommends -y openssl tar

|

||||

|

||||

# Create working directory

|

||||

WORKDIR /usr/src/ultralytics

|

||||

|

||||

# Copy contents

|

||||

# COPY . /usr/src/ultralytics # git permission issues inside container

|

||||

RUN git clone https://github.com/ultralytics/ultralytics -b main /usr/src/ultralytics

|

||||

ADD https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8n.pt /usr/src/ultralytics/

|

||||

|

||||

# Install pip packages

|

||||

RUN python3 -m pip install --upgrade pip wheel

|

||||

RUN pip install --no-cache -e ".[export]" albumentations comet pycocotools pytest-cov

|

||||

|

||||

# Run exports to AutoInstall packages

|

||||

RUN yolo export model=tmp/yolov8n.pt format=edgetpu imgsz=32

|

||||

RUN yolo export model=tmp/yolov8n.pt format=ncnn imgsz=32

|

||||

# Requires <= Python 3.10, bug with paddlepaddle==2.5.0 https://github.com/PaddlePaddle/X2Paddle/issues/991

|

||||

RUN pip install --no-cache paddlepaddle==2.4.2 x2paddle

|

||||

# Fix error: `np.bool` was a deprecated alias for the builtin `bool` segmentation error in Tests

|

||||

RUN pip install --no-cache numpy==1.23.5

|

||||

# Remove exported models

|

||||

RUN rm -rf tmp

|

||||

|

||||

# Set environment variables

|

||||

ENV OMP_NUM_THREADS=1

|

||||

# Avoid DDP error "MKL_THREADING_LAYER=INTEL is incompatible with libgomp.so.1 library" https://github.com/pytorch/pytorch/issues/37377

|

||||

ENV MKL_THREADING_LAYER=GNU

|

||||

|

||||

|

||||

# Usage Examples -------------------------------------------------------------------------------------------------------

|

||||

|

||||

# Build and Push

|

||||

# t=ultralytics/ultralytics:latest && sudo docker build -f docker/Dockerfile -t $t . && sudo docker push $t

|

||||

|

||||

# Pull and Run with access to all GPUs

|

||||

# t=ultralytics/ultralytics:latest && sudo docker pull $t && sudo docker run -it --ipc=host --gpus all $t

|

||||

|

||||

# Pull and Run with access to GPUs 2 and 3 (inside container CUDA devices will appear as 0 and 1)

|

||||

# t=ultralytics/ultralytics:latest && sudo docker pull $t && sudo docker run -it --ipc=host --gpus '"device=2,3"' $t

|

||||

|

||||

# Pull and Run with local directory access

|

||||

# t=ultralytics/ultralytics:latest && sudo docker pull $t && sudo docker run -it --ipc=host --gpus all -v "$(pwd)"/datasets:/usr/src/datasets $t

|

||||

|

||||

# Kill all

|

||||

# sudo docker kill $(sudo docker ps -q)

|

||||

|

||||

# Kill all image-based

|

||||

# sudo docker kill $(sudo docker ps -qa --filter ancestor=ultralytics/ultralytics:latest)

|

||||

|

||||

# DockerHub tag update

|

||||

# t=ultralytics/ultralytics:latest tnew=ultralytics/ultralytics:v6.2 && sudo docker pull $t && sudo docker tag $t $tnew && sudo docker push $tnew

|

||||

|

||||

# Clean up

|

||||

# sudo docker system prune -a --volumes

|

||||

|

||||

# Update Ubuntu drivers

|

||||

# https://www.maketecheasier.com/install-nvidia-drivers-ubuntu/

|

||||

|

||||

# DDP test

|

||||

# python -m torch.distributed.run --nproc_per_node 2 --master_port 1 train.py --epochs 3

|

||||

|

||||

# GCP VM from Image

|

||||

# docker.io/ultralytics/ultralytics:latest

|

||||

|

|

@ -1,44 +0,0 @@

|

|||

# Ultralytics YOLO 🚀, AGPL-3.0 license

|

||||

# Builds ultralytics/ultralytics:latest-arm64 image on DockerHub https://hub.docker.com/r/ultralytics/ultralytics

|

||||

# Image is aarch64-compatible for Apple M1 and other ARM architectures i.e. Jetson Nano and Raspberry Pi

|

||||

|

||||

# Start FROM Ubuntu image https://hub.docker.com/_/ubuntu

|

||||

FROM arm64v8/ubuntu:22.04

|

||||

|

||||

# Downloads to user config dir

|

||||

ADD https://ultralytics.com/assets/Arial.ttf https://ultralytics.com/assets/Arial.Unicode.ttf /root/.config/Ultralytics/

|

||||

|

||||

# Install linux packages

|

||||

# g++ required to build 'tflite_support' and 'lap' packages, libusb-1.0-0 required for 'tflite_support' package

|

||||

RUN apt update \

|

||||

&& apt install --no-install-recommends -y python3-pip git zip curl htop gcc libgl1 libglib2.0-0 libpython3-dev gnupg g++ libusb-1.0-0

|

||||

|

||||

# Create working directory

|

||||

WORKDIR /usr/src/ultralytics

|

||||

|

||||

# Copy contents

|

||||

# COPY . /usr/src/ultralytics # git permission issues inside container

|

||||

RUN git clone https://github.com/ultralytics/ultralytics -b main /usr/src/ultralytics

|

||||

ADD https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8n.pt /usr/src/ultralytics/

|

||||

|

||||

# Install pip packages

|

||||

RUN python3 -m pip install --upgrade pip wheel

|

||||

RUN pip install --no-cache -e .

|

||||

|

||||

# Creates a symbolic link to make 'python' point to 'python3'

|

||||

RUN ln -sf /usr/bin/python3 /usr/bin/python

|

||||

|

||||

|

||||

# Usage Examples -------------------------------------------------------------------------------------------------------

|

||||

|

||||

# Build and Push

|

||||

# t=ultralytics/ultralytics:latest-arm64 && sudo docker build --platform linux/arm64 -f docker/Dockerfile-arm64 -t $t . && sudo docker push $t

|

||||

|

||||

# Run

|

||||

# t=ultralytics/ultralytics:latest-arm64 && sudo docker run -it --ipc=host $t

|

||||

|

||||

# Pull and Run

|

||||

# t=ultralytics/ultralytics:latest-arm64 && sudo docker pull $t && sudo docker run -it --ipc=host $t

|

||||

|

||||

# Pull and Run with local volume mounted

|

||||

# t=ultralytics/ultralytics:latest-arm64 && sudo docker pull $t && sudo docker run -it --ipc=host -v "$(pwd)"/datasets:/usr/src/datasets $t

|

||||

|

|

@ -1,38 +0,0 @@

|

|||

# Ultralytics YOLO 🚀, AGPL-3.0 license

|

||||

# Builds ultralytics/ultralytics:latest-conda image on DockerHub https://hub.docker.com/r/ultralytics/ultralytics

|

||||

# Image is optimized for Ultralytics Anaconda (https://anaconda.org/conda-forge/ultralytics) installation and usage

|

||||

|

||||

# Start FROM miniconda3 image https://hub.docker.com/r/continuumio/miniconda3

|

||||

FROM continuumio/miniconda3:latest

|

||||

|

||||

# Downloads to user config dir

|

||||

ADD https://ultralytics.com/assets/Arial.ttf https://ultralytics.com/assets/Arial.Unicode.ttf /root/.config/Ultralytics/

|

||||

|

||||

# Install linux packages

|

||||

RUN apt update \

|

||||

&& apt install --no-install-recommends -y libgl1

|

||||

|

||||

# Copy contents

|

||||

ADD https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8n.pt .

|

||||

|

||||

# Install conda packages

|

||||

# mkl required to fix 'OSError: libmkl_intel_lp64.so.2: cannot open shared object file: No such file or directory'

|

||||

RUN conda config --set solver libmamba && \

|

||||

conda install pytorch torchvision pytorch-cuda=11.8 -c pytorch -c nvidia && \

|

||||

conda install -c conda-forge ultralytics mkl

|

||||

# conda install -c pytorch -c nvidia -c conda-forge pytorch torchvision pytorch-cuda=11.8 ultralytics mkl

|

||||

|

||||

|

||||

# Usage Examples -------------------------------------------------------------------------------------------------------

|

||||

|

||||

# Build and Push

|

||||

# t=ultralytics/ultralytics:latest-conda && sudo docker build -f docker/Dockerfile-cpu -t $t . && sudo docker push $t

|

||||

|

||||

# Run

|

||||

# t=ultralytics/ultralytics:latest-conda && sudo docker run -it --ipc=host $t

|

||||

|

||||

# Pull and Run

|

||||

# t=ultralytics/ultralytics:latest-conda && sudo docker pull $t && sudo docker run -it --ipc=host $t

|

||||

|

||||

# Pull and Run with local volume mounted

|

||||

# t=ultralytics/ultralytics:latest-conda && sudo docker pull $t && sudo docker run -it --ipc=host -v "$(pwd)"/datasets:/usr/src/datasets $t

|

||||

|

|

@ -1,55 +0,0 @@

|

|||

# Ultralytics YOLO 🚀, AGPL-3.0 license

|

||||

# Builds ultralytics/ultralytics:latest-cpu image on DockerHub https://hub.docker.com/r/ultralytics/ultralytics

|

||||

# Image is CPU-optimized for ONNX, OpenVINO and PyTorch YOLOv8 deployments

|

||||

|

||||

# Start FROM Ubuntu image https://hub.docker.com/_/ubuntu

|

||||

FROM ubuntu:mantic-20231011

|

||||

|

||||

# Downloads to user config dir

|

||||

ADD https://ultralytics.com/assets/Arial.ttf https://ultralytics.com/assets/Arial.Unicode.ttf /root/.config/Ultralytics/

|

||||

|

||||

# Install linux packages

|

||||

# g++ required to build 'tflite_support' and 'lap' packages, libusb-1.0-0 required for 'tflite_support' package

|

||||

RUN apt update \

|

||||

&& apt install --no-install-recommends -y python3-pip git zip curl htop libgl1 libglib2.0-0 libpython3-dev gnupg g++ libusb-1.0-0

|

||||

|

||||

# Create working directory

|

||||

WORKDIR /usr/src/ultralytics

|

||||

|

||||

# Copy contents

|

||||

# COPY . /usr/src/ultralytics # git permission issues inside container

|

||||

RUN git clone https://github.com/ultralytics/ultralytics -b main /usr/src/ultralytics

|

||||

ADD https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8n.pt /usr/src/ultralytics/

|

||||

|

||||

# Remove python3.11/EXTERNALLY-MANAGED or use 'pip install --break-system-packages' avoid 'externally-managed-environment' Ubuntu nightly error

|

||||

RUN rm -rf /usr/lib/python3.11/EXTERNALLY-MANAGED

|

||||

|

||||

# Install pip packages

|

||||

RUN python3 -m pip install --upgrade pip wheel

|

||||

RUN pip install --no-cache -e ".[export]" --extra-index-url https://download.pytorch.org/whl/cpu

|

||||

|

||||

# Run exports to AutoInstall packages

|

||||

RUN yolo export model=tmp/yolov8n.pt format=edgetpu imgsz=32

|

||||

RUN yolo export model=tmp/yolov8n.pt format=ncnn imgsz=32

|

||||

# Requires <= Python 3.10, bug with paddlepaddle==2.5.0 https://github.com/PaddlePaddle/X2Paddle/issues/991

|

||||

# RUN pip install --no-cache paddlepaddle==2.4.2 x2paddle

|

||||

# Remove exported models

|

||||

RUN rm -rf tmp

|

||||

|

||||

# Creates a symbolic link to make 'python' point to 'python3'

|

||||

RUN ln -sf /usr/bin/python3 /usr/bin/python

|

||||

|

||||

|

||||

# Usage Examples -------------------------------------------------------------------------------------------------------

|

||||

|

||||

# Build and Push

|

||||

# t=ultralytics/ultralytics:latest-cpu && sudo docker build -f docker/Dockerfile-cpu -t $t . && sudo docker push $t

|

||||

|

||||

# Run

|

||||

# t=ultralytics/ultralytics:latest-cpu && sudo docker run -it --ipc=host $t

|

||||

|

||||

# Pull and Run

|

||||

# t=ultralytics/ultralytics:latest-cpu && sudo docker pull $t && sudo docker run -it --ipc=host $t

|

||||

|

||||

# Pull and Run with local volume mounted

|

||||

# t=ultralytics/ultralytics:latest-cpu && sudo docker pull $t && sudo docker run -it --ipc=host -v "$(pwd)"/datasets:/usr/src/datasets $t

|

||||

|

|

@ -1,48 +0,0 @@

|

|||

# Ultralytics YOLO 🚀, AGPL-3.0 license

|

||||

# Builds ultralytics/ultralytics:jetson image on DockerHub https://hub.docker.com/r/ultralytics/ultralytics

|

||||

# Supports JetPack for YOLOv8 on Jetson Nano, TX1/TX2, Xavier NX, AGX Xavier, AGX Orin, and Orin NX

|

||||

|

||||

# Start FROM https://catalog.ngc.nvidia.com/orgs/nvidia/containers/l4t-pytorch

|

||||

FROM nvcr.io/nvidia/l4t-pytorch:r35.2.1-pth2.0-py3

|

||||

|

||||

# Downloads to user config dir

|

||||

ADD https://ultralytics.com/assets/Arial.ttf https://ultralytics.com/assets/Arial.Unicode.ttf /root/.config/Ultralytics/

|

||||

|

||||

# Install linux packages

|

||||

# g++ required to build 'tflite_support' and 'lap' packages, libusb-1.0-0 required for 'tflite_support' package

|

||||

RUN apt update \

|

||||

&& apt install --no-install-recommends -y gcc git zip curl htop libgl1 libglib2.0-0 libpython3-dev gnupg g++ libusb-1.0-0

|

||||

|

||||

# Create working directory

|

||||

WORKDIR /usr/src/ultralytics

|

||||

|

||||

# Copy contents

|

||||

# COPY . /usr/src/ultralytics # git permission issues inside container

|

||||

RUN git clone https://github.com/ultralytics/ultralytics -b main /usr/src/ultralytics

|

||||

ADD https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8n.pt /usr/src/ultralytics/

|

||||

|

||||

# Remove opencv-python from requirements.txt as it conflicts with opencv-python installed in base image

|

||||

RUN grep -v '^opencv-python' requirements.txt > tmp.txt && mv tmp.txt requirements.txt

|

||||

|

||||

# Install pip packages manually for TensorRT compatibility https://github.com/NVIDIA/TensorRT/issues/2567

|

||||

RUN python3 -m pip install --upgrade pip wheel

|

||||

RUN pip install --no-cache tqdm matplotlib pyyaml psutil pandas onnx "numpy==1.23"

|

||||

RUN pip install --no-cache -e .

|

||||

|

||||

# Set environment variables

|

||||

ENV OMP_NUM_THREADS=1

|

||||

|

||||

|

||||

# Usage Examples -------------------------------------------------------------------------------------------------------

|

||||

|

||||

# Build and Push

|

||||

# t=ultralytics/ultralytics:latest-jetson && sudo docker build --platform linux/arm64 -f docker/Dockerfile-jetson -t $t . && sudo docker push $t

|

||||

|

||||

# Run

|

||||

# t=ultralytics/ultralytics:latest-jetson && sudo docker run -it --ipc=host $t

|

||||

|

||||

# Pull and Run

|

||||

# t=ultralytics/ultralytics:latest-jetson && sudo docker pull $t && sudo docker run -it --ipc=host $t

|

||||

|

||||

# Pull and Run with NVIDIA runtime

|

||||

# t=ultralytics/ultralytics:latest-jetson && sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

|

||||

|

|

@ -1,52 +0,0 @@

|

|||

# Ultralytics YOLO 🚀, AGPL-3.0 license

|

||||

# Builds ultralytics/ultralytics:latest-cpu image on DockerHub https://hub.docker.com/r/ultralytics/ultralytics

|

||||

# Image is CPU-optimized for ONNX, OpenVINO and PyTorch YOLOv8 deployments

|

||||

|

||||

# Use the official Python 3.10 slim-bookworm as base image

|

||||

FROM python:3.10-slim-bookworm

|

||||

|

||||

# Downloads to user config dir

|

||||

ADD https://ultralytics.com/assets/Arial.ttf https://ultralytics.com/assets/Arial.Unicode.ttf /root/.config/Ultralytics/

|

||||

|

||||

# Install linux packages

|

||||

# g++ required to build 'tflite_support' and 'lap' packages, libusb-1.0-0 required for 'tflite_support' package

|

||||

RUN apt update \

|

||||

&& apt install --no-install-recommends -y python3-pip git zip curl htop libgl1 libglib2.0-0 libpython3-dev gnupg g++ libusb-1.0-0

|

||||

|

||||

# Create working directory

|

||||

WORKDIR /usr/src/ultralytics

|

||||

|

||||

# Copy contents

|

||||

# COPY . /usr/src/ultralytics # git permission issues inside container

|

||||

RUN git clone https://github.com/ultralytics/ultralytics -b main /usr/src/ultralytics

|

||||

ADD https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8n.pt /usr/src/ultralytics/

|

||||

|

||||

# Remove python3.11/EXTERNALLY-MANAGED or use 'pip install --break-system-packages' avoid 'externally-managed-environment' Ubuntu nightly error

|

||||

# RUN rm -rf /usr/lib/python3.11/EXTERNALLY-MANAGED

|

||||

|

||||

# Install pip packages

|

||||

RUN python3 -m pip install --upgrade pip wheel

|

||||

RUN pip install --no-cache -e ".[export]" --extra-index-url https://download.pytorch.org/whl/cpu

|

||||

|

||||

# Run exports to AutoInstall packages

|

||||

RUN yolo export model=tmp/yolov8n.pt format=edgetpu imgsz=32

|

||||

RUN yolo export model=tmp/yolov8n.pt format=ncnn imgsz=32

|

||||

# Requires <= Python 3.10, bug with paddlepaddle==2.5.0 https://github.com/PaddlePaddle/X2Paddle/issues/991

|

||||

RUN pip install --no-cache paddlepaddle==2.4.2 x2paddle

|

||||

# Remove exported models

|

||||

RUN rm -rf tmp

|

||||

|

||||

|

||||

# Usage Examples -------------------------------------------------------------------------------------------------------

|

||||

|

||||

# Build and Push

|

||||

# t=ultralytics/ultralytics:latest-python && sudo docker build -f docker/Dockerfile-python -t $t . && sudo docker push $t

|

||||

|

||||

# Run

|

||||

# t=ultralytics/ultralytics:latest-python && sudo docker run -it --ipc=host $t

|

||||

|

||||

# Pull and Run

|

||||

# t=ultralytics/ultralytics:latest-python && sudo docker pull $t && sudo docker run -it --ipc=host $t

|

||||

|

||||

# Pull and Run with local volume mounted

|

||||

# t=ultralytics/ultralytics:latest-python && sudo docker pull $t && sudo docker run -it --ipc=host -v "$(pwd)"/datasets:/usr/src/datasets $t

|

||||

|

|

@ -1,38 +0,0 @@

|

|||

# Ultralytics YOLO 🚀, AGPL-3.0 license

|

||||

# Builds GitHub actions CI runner image for deployment to DockerHub https://hub.docker.com/r/ultralytics/ultralytics

|

||||

# Image is CUDA-optimized for YOLOv8 single/multi-GPU training and inference tests

|

||||

|

||||

# Start FROM Ultralytics GPU image

|

||||

FROM ultralytics/ultralytics:latest

|

||||

|

||||

# Set the working directory

|

||||

WORKDIR /actions-runner

|

||||

|

||||

# Download and unpack the latest runner from https://github.com/actions/runner

|

||||

RUN FILENAME=actions-runner-linux-x64-2.309.0.tar.gz && \

|

||||

curl -o $FILENAME -L https://github.com/actions/runner/releases/download/v2.309.0/$FILENAME && \

|

||||

tar xzf $FILENAME && \

|

||||

rm $FILENAME

|

||||

|

||||

# Install runner dependencies

|

||||

ENV RUNNER_ALLOW_RUNASROOT=1

|

||||

ENV DEBIAN_FRONTEND=noninteractive

|

||||

RUN ./bin/installdependencies.sh && \

|

||||

apt-get -y install libicu-dev

|

||||

|

||||

# Inline ENTRYPOINT command to configure and start runner with default TOKEN and NAME

|

||||

ENTRYPOINT sh -c './config.sh --url https://github.com/ultralytics/ultralytics \

|

||||

--token ${GITHUB_RUNNER_TOKEN:-TOKEN} \

|

||||

--name ${GITHUB_RUNNER_NAME:-NAME} \

|

||||

--labels gpu-latest \

|

||||

--replace && \

|

||||

./run.sh'

|

||||

|

||||

|

||||

# Usage Examples -------------------------------------------------------------------------------------------------------

|

||||

|

||||

# Build and Push

|

||||

# t=ultralytics/ultralytics:latest-runner && sudo docker build -f docker/Dockerfile-runner -t $t . && sudo docker push $t

|

||||

|

||||

# Pull and Run in detached mode with access to GPUs 0 and 1

|

||||

# t=ultralytics/ultralytics:latest-runner && sudo docker run -d -e GITHUB_RUNNER_TOKEN=TOKEN -e GITHUB_RUNNER_NAME=NAME --ipc=host --gpus '"device=0,1"' $t

|

||||

102

docs/README.md

102

docs/README.md

|

|

@ -1,102 +0,0 @@

|

|||

# Ultralytics Docs

|

||||

|

||||

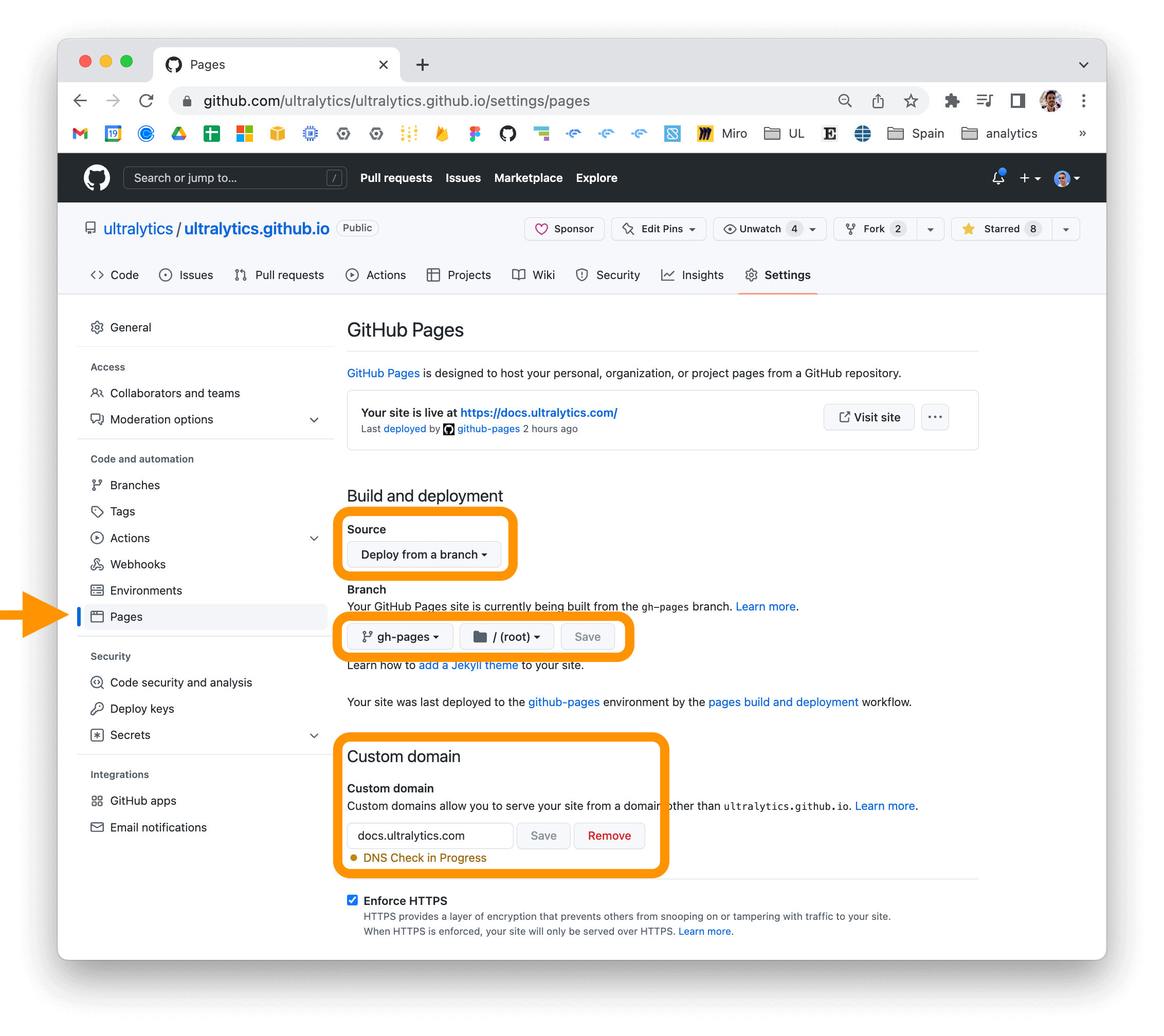

Ultralytics Docs are deployed to [https://docs.ultralytics.com](https://docs.ultralytics.com).

|

||||

|

||||

[](https://github.com/ultralytics/docs/actions/workflows/pages/pages-build-deployment) [](https://github.com/ultralytics/docs/actions/workflows/links.yml)

|

||||

|

||||

### Install Ultralytics package

|

||||

|

||||

[](https://badge.fury.io/py/ultralytics) [](https://pepy.tech/project/ultralytics)

|

||||

|

||||

To install the ultralytics package in developer mode, you will need to have Git and Python 3 installed on your system. Then, follow these steps:

|

||||

|

||||

1. Clone the ultralytics repository to your local machine using Git:

|

||||

|

||||

```bash

|

||||

git clone https://github.com/ultralytics/ultralytics.git

|

||||

```

|

||||

|

||||

2. Navigate to the root directory of the repository:

|

||||

|

||||

```bash

|

||||

cd ultralytics

|

||||

```

|

||||

|

||||

3. Install the package in developer mode using pip:

|

||||

|

||||

```bash

|

||||

pip install -e '.[dev]'

|

||||

```

|

||||

|

||||

This will install the ultralytics package and its dependencies in developer mode, allowing you to make changes to the package code and have them reflected immediately in your Python environment.

|

||||

|

||||

Note that you may need to use the pip3 command instead of pip if you have multiple versions of Python installed on your system.

|

||||

|

||||

### Building and Serving Locally

|

||||

|

||||

The `mkdocs serve` command is used to build and serve a local version of the MkDocs documentation site. It is typically used during the development and testing phase of a documentation project.

|

||||

|

||||

```bash

|

||||

mkdocs serve

|

||||

```

|

||||

|

||||

Here is a breakdown of what this command does:

|

||||

|

||||

- `mkdocs`: This is the command-line interface (CLI) for the MkDocs static site generator. It is used to build and serve MkDocs sites.

|

||||

- `serve`: This is a subcommand of the `mkdocs` CLI that tells it to build and serve the documentation site locally.

|

||||

- `-a`: This flag specifies the hostname and port number to bind the server to. The default value is `localhost:8000`.

|

||||

- `-t`: This flag specifies the theme to use for the documentation site. The default value is `mkdocs`.

|

||||

- `-s`: This flag tells the `serve` command to serve the site in silent mode, which means it will not display any log messages or progress updates. When you run the `mkdocs serve` command, it will build the documentation site using the files in the `docs/` directory and serve it at the specified hostname and port number. You can then view the site by going to the URL in your web browser.

|

||||

|

||||

While the site is being served, you can make changes to the documentation files and see them reflected in the live site immediately. This is useful for testing and debugging your documentation before deploying it to a live server.

|

||||

|

||||

To stop the serve command and terminate the local server, you can use the `CTRL+C` keyboard shortcut.

|

||||

|

||||

### Building and Serving Multi-Language

|

||||

|

||||

For multi-language MkDocs sites use the following additional steps:

|

||||

|

||||

1. Add all new language *.md files to git commit: `git add docs/**/*.md -f`

|

||||

2. Build all languages to the `/site` directory. Verify that the top-level `/site` directory contains `CNAME`, `robots.txt` and `sitemap.xml` files, if applicable.

|

||||

|

||||

```bash

|

||||

# Remove existing /site directory

|

||||

rm -rf site

|

||||

|

||||

# Loop through all *.yml files in the docs directory

|

||||

mkdocs build -f docs/mkdocs.yml

|

||||

for file in docs/mkdocs_*.yml; do

|

||||

echo "Building MkDocs site with configuration file: $file"

|

||||

mkdocs build -f "$file"

|

||||

done

|

||||

```

|

||||

|

||||

3. Preview in web browser with:

|

||||

|

||||

```bash

|

||||

cd site

|

||||

python -m http.server

|

||||

open http://localhost:8000 # on macOS

|

||||

```

|

||||

|

||||

Note the above steps are combined into the Ultralytics [build_docs.py](https://github.com/ultralytics/ultralytics/blob/main/docs/build_docs.py) script.

|

||||

|

||||

### Deploying Your Documentation Site

|

||||

|

||||

To deploy your MkDocs documentation site, you will need to choose a hosting provider and a deployment method. Some popular options include GitHub Pages, GitLab Pages, and Amazon S3.

|

||||

|

||||

Before you can deploy your site, you will need to configure your `mkdocs.yml` file to specify the remote host and any other necessary deployment settings.

|

||||

|

||||

Once you have configured your `mkdocs.yml` file, you can use the `mkdocs deploy` command to build and deploy your site. This command will build the documentation site using the files in the `docs/` directory and the specified configuration file and theme, and then deploy the site to the specified remote host.

|

||||

|

||||

For example, to deploy your site to GitHub Pages using the gh-deploy plugin, you can use the following command:

|

||||

|

||||

```bash

|

||||

mkdocs gh-deploy

|

||||

```

|

||||

|

||||

If you are using GitHub Pages, you can set a custom domain for your documentation site by going to the "Settings" page for your repository and updating the "Custom domain" field in the "GitHub Pages" section.

|

||||

|

||||

|

||||

|

||||

For more information on deploying your MkDocs documentation site, see the [MkDocs documentation](https://www.mkdocs.org/user-guide/deploying-your-docs/).

|

||||

|

|

@ -1,82 +0,0 @@

|

|||

---

|

||||

comments: true

|

||||

description: استكشف دليل كامل لـ Ultralytics YOLOv8 ، نموذج كشف الكائنات وتجزئة الصور ذو السرعة العالية والدقة العالية. تثبيت المحررة ، والتنبؤ ، والتدريب والمزيد.

|

||||

keywords: Ultralytics، YOLOv8، كشف الكائنات، تجزئة الصور، التعلم الآلي، التعلم العميق، الرؤية الحاسوبية، YOLOv8 installation، YOLOv8 prediction، YOLOv8 training، تاريخ YOLO، تراخيص YOLO

|

||||

---

|

||||

|

||||

<div align="center">

|

||||

<p>

|

||||

<a href="https://yolovision.ultralytics.com" target="_blank">

|

||||

<img width="1024" src="https://raw.githubusercontent.com/ultralytics/assets/main/yolov8/banner-yolov8.png" alt="Ultralytics YOLO banner"></a>

|

||||

</p>

|

||||

<a href="https://github.com/ultralytics"><img src="https://github.com/ultralytics/assets/raw/main/social/logo-social-github.png" width="3%" alt="Ultralytics GitHub"></a>

|

||||

<img src="https://github.com/ultralytics/assets/raw/main/social/logo-transparent.png" width="3%" alt="space">

|

||||

<a href="https://www.linkedin.com/company/ultralytics/"><img src="https://github.com/ultralytics/assets/raw/main/social/logo-social-linkedin.png" width="3%" alt="Ultralytics LinkedIn"></a>

|

||||

<img src="https://github.com/ultralytics/assets/raw/main/social/logo-transparent.png" width="3%" alt="space">

|

||||

<a href="https://twitter.com/ultralytics"><img src="https://github.com/ultralytics/assets/raw/main/social/logo-social-twitter.png" width="3%" alt="Ultralytics Twitter"></a>

|

||||

<img src="https://github.com/ultralytics/assets/raw/main/social/logo-transparent.png" width="3%" alt="space">

|

||||

<a href="https://youtube.com/ultralytics"><img src="https://github.com/ultralytics/assets/raw/main/social/logo-social-youtube.png" width="3%" alt="Ultralytics YouTube"></a>

|

||||

<img src="https://github.com/ultralytics/assets/raw/main/social/logo-transparent.png" width="3%" alt="space">

|

||||

<a href="https://www.tiktok.com/@ultralytics"><img src="https://github.com/ultralytics/assets/raw/main/social/logo-social-tiktok.png" width="3%" alt="Ultralytics TikTok"></a>

|

||||

<img src="https://github.com/ultralytics/assets/raw/main/social/logo-transparent.png" width="3%" alt="space">

|

||||

<a href="https://www.instagram.com/ultralytics/"><img src="https://github.com/ultralytics/assets/raw/main/social/logo-social-instagram.png" width="3%" alt="Ultralytics Instagram"></a>

|

||||

<img src="https://github.com/ultralytics/assets/raw/main/social/logo-transparent.png" width="3%" alt="space">

|

||||

<a href="https://ultralytics.com/discord"><img src="https://github.com/ultralytics/assets/raw/main/social/logo-social-discord.png" width="3%" alt="Ultralytics Discord"></a>

|

||||

<br>

|

||||

<br>

|

||||

<a href="https://github.com/ultralytics/ultralytics/actions/workflows/ci.yaml"><img src="https://github.com/ultralytics/ultralytics/actions/workflows/ci.yaml/badge.svg" alt="Ultralytics CI"></a>

|

||||

<a href="https://codecov.io/github/ultralytics/ultralytics"><img src="https://codecov.io/github/ultralytics/ultralytics/branch/main/graph/badge.svg?token=HHW7IIVFVY" alt="Ultralytics Code Coverage"></a>

|

||||

<a href="https://zenodo.org/badge/latestdoi/264818686"><img src="https://zenodo.org/badge/264818686.svg" alt="YOLOv8 Citation"></a>

|

||||

<a href="https://hub.docker.com/r/ultralytics/ultralytics"><img src="https://img.shields.io/docker/pulls/ultralytics/ultralytics?logo=docker" alt="Docker Pulls"></a>

|

||||

<br>

|

||||

<a href="https://console.paperspace.com/github/ultralytics/ultralytics"><img src="https://assets.paperspace.io/img/gradient-badge.svg" alt="Run on Gradient"></a>

|

||||

<a href="https://colab.research.google.com/github/ultralytics/ultralytics/blob/main/examples/tutorial.ipynb"><img src="https://colab.research.google.com/assets/colab-badge.svg" alt="Open In Colab"></a>

|

||||

<a href="https://www.kaggle.com/ultralytics/yolov8"><img src="https://kaggle.com/static/images/open-in-kaggle.svg" alt="Open In Kaggle"></a>

|

||||

</div>

|

||||

|

||||

يتم تقديم [Ultralytics](https://ultralytics.com) [YOLOv8](https://github.com/ultralytics/ultralytics) ، أحدث إصدار من نموذج كشف الكائنات وتجزئة الصور المشهورة للوقت الفعلي. يعتمد YOLOv8 على التطورات المتقدمة في التعلم العميق والرؤية الحاسوبية ، ويقدم أداءً فائقًا من حيث السرعة والدقة. يجعل التصميم البسيط له مناسبًا لمختلف التطبيقات وقابلًا للتكيف بسهولة مع منصات الأجهزة المختلفة ، من الأجهزة الحافة إلى واجهات برمجة التطبيقات في السحابة.

|

||||

|

||||

استكشف أدلة YOLOv8 ، وهي مورد شامل يهدف إلى مساعدتك في فهم واستخدام ميزاته وقدراته. سواء كنت ممارسًا في مجال التعلم الآلي من ذوي الخبرة أو جديدًا في هذا المجال ، فإن الهدف من هذا المركز هو تحقيق الحد الأقصى لإمكانات YOLOv8 في مشاريعك.

|

||||

|

||||

!!! Note "ملاحظة"

|

||||

|

||||

🚧 تم تطوير وثائقنا متعددة اللغات حاليًا ، ونعمل بجد لتحسينها. شكراً لصبرك! 🙏

|

||||

|

||||

## من أين أبدأ

|

||||

|

||||

- **تثبيت** `ultralytics` بواسطة pip والبدء في العمل في دقائق [:material-clock-fast: ابدأ الآن](quickstart.md){ .md-button }

|

||||

- **توقع** الصور ومقاطع الفيديو الجديدة بواسطة YOLOv8 [:octicons-image-16: توقع على الصور](modes/predict.md){ .md-button }

|

||||

- **تدريب** نموذج YOLOv8 الجديد على مجموعة البيانات المخصصة الخاصة بك [:fontawesome-solid-brain: قم بتدريب نموذج](modes/train.md){ .md-button }

|

||||

- **استكشاف** مهام YOLOv8 مثل التجزئة والتصنيف والوضع والتتبع [:material-magnify-expand: استكشاف المهام](tasks/index.md){ .md-button }

|

||||

|

||||

<p align="center">

|

||||

<br>

|

||||

<iframe width="720" height="405" src="https://www.youtube.com/embed/LNwODJXcvt4?si=7n1UvGRLSd9p5wKs"

|

||||

title="مشغل فيديو يوتيوب" frameborder="0"

|

||||

allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture; web-share"

|

||||

allowfullscreen>

|

||||

</iframe>

|

||||

<br>

|

||||

<strong> مشاهدة: </strong> كيفية تدريب نموذج YOLOv8 على مجموعة بيانات مخصصة في <a href="https://colab.research.google.com/github/ultralytics/ultralytics/blob/main/examples/tutorial.ipynb" target="_blank">جوجل كولاب</a>.

|

||||

</p>

|

||||

|

||||

## YOLO: نبذة تاريخية

|

||||

|

||||

تم تطوير [YOLO](https://arxiv.org/abs/1506.02640) (You Only Look Once) ، نموذج شهير لكشف الكائنات وتجزئة الصور ، من قبل جوزيف ريدمون وعلي فرهادي في جامعة واشنطن. في عام 2015 ، حققت YOLO شهرة سريعة بفضل سرعتها العالية ودقتها.

|

||||

|

||||

- [YOLOv2](https://arxiv.org/abs/1612.08242) ، الذي تم إصداره في عام 2016 ، قام بتحسين النموذج الأصلي من خلال دمج التطبيع التشغيلي ، ومربعات الربط ، ومجموعات الأبعاد.

|

||||

- [YOLOv3](https://pjreddie.com/media/files/papers/YOLOv3.pdf) ، الذي تم إطلاقه في عام 2018 ، قدم تحسينات إضافية لأداء النموذج باستخدام شبكة ظهر أكثر كفاءة ومرشحات متعددة وتجميع هرم المساحة.

|

||||

- تم إصدار [YOLOv4](https://arxiv.org/abs/2004.10934) في عام 2020 ، وقدم ابتكارات مثل زيادة المساعدات في البيانات ، ورأس جديد للكشف غير المرتبط بالمرابط ، ووظيفة فقدان جديدة.

|

||||

- [YOLOv5](https://github.com/ultralytics/yolov5) قام بتحسين أداء النموذج وأضاف ميزات جديدة مثل تحسين ثوابت النموذج ، وتعقب التجارب المتكامل والتصدير التلقائي إلى تنسيقات التصدير الشهيرة.

|

||||

- [YOLOv6](https://github.com/meituan/YOLOv6) تم تَوْزيعه على [Meituan](https://about.meituan.com/) في عام 2022 وهو قيد الاستخدام في العديد من روبوتات التسليم الذاتي للشركة.

|

||||

- [YOLOv7](https://github.com/WongKinYiu/yolov7) أضاف مهمات إضافية مثل تقدير الوضع على مجموعة بيانات نقاط COCO الرئيسية.

|

||||

- [YOLOv8](https://github.com/ultralytics/ultralytics) هو أحدث إصدار من YOLO بواسطة Ultralytics. باعتباره نموذجًا حديثًا وفريدًا من نوعه ، فإن YOLOv8 يبني على نجاح الإصدارات السابقة ، ويقدم ميزات وتحسينات جديدة لتحسين الأداء والمرونة والكفاءة. يدعم YOLOv8 مجموعة كاملة من مهام الذكاء الصناعي للرؤية ، بما في ذلك [الكشف](tasks/detect.md) ، [التجزئة](tasks/segment.md) ، [تقدير الوضع](tasks/pose.md) ، [التتبع](modes/track.md) ، و [التصنيف](tasks/classify.md). تتيح هذه القابلية للتكيف للمستخدمين استغلال قدرات YOLOv8 في تطبيقات ومجالات متنوعة.

|

||||

|

||||

## تراخيص YOLO: كيف يتم ترخيص Ultralytics YOLO؟

|

||||

|

||||

يوفر Ultralytics خيارين للترخيص لاستيعاب الحالات الاستخدام المتنوعة:

|

||||

|

||||

- **ترخيص AGPL-3.0**: هذا الترخيص مفتوح المصدر والمعتمد من [OSI](https://opensource.org/licenses/) وهو مثالي للطلاب والهواة ، ويشجع على التعاون المفتوح ومشاركة المعرفة. راجع ملف [LICENSE](https://github.com/ultralytics/ultralytics/blob/main/LICENSE) لمزيد من التفاصيل.

|

||||

- **ترخيص المؤسسة**: صمم للاستخدام التجاري ، يسمح هذا الترخيص بدمج سلس للبرمجيات ونماذج AI الخاصة بشركة Ultralytics في السلع والخدمات التجارية ، وتفادي متطلبات المصدر المفتوح لـ AGPL-3.0. إذا تشمل سيناريو الخاص بك تضمين حلولنا في عرض تجاري ، فيرجى التواصل من خلال [Ultralytics Licensing](https://ultralytics.com/license).

|

||||

|

||||

تم تصميم استراتيجية الترخيص الخاصة بنا لضمان أن أي تحسينات على مشاريعنا مفتوحة المصدر يتم إرجاعها إلى المجتمع. نحمل مبادئ المصدر المفتوح قريبة من قلوبنا ❤️ ، ومهمتنا هي ضمان أن يمكن استخدام وتوسيع مساهماتنا بطرق تعود بالنفع على الجميع.

|

||||

|

|

@ -1,191 +0,0 @@

|

|||

---

|

||||

comments: true

|

||||

description: استكشف FastSAM ، وهو حلاً مبنيًا على الشبكات العصبية السريعة لتجزئة الكائنات في الوقت الحقيقي في الصور. تفاعل المستخدم المحسّن ، والكفاءة الحسابية ، والقابلية للتكيف في مهام الرؤية المختلفة.

|

||||

keywords: FastSAM ، التعلم الآلي ، حلاً مبنيًا على الشبكات العصبية السريعة ، قسيمة الكائنات ، حلاً في الوقت الحقيقي ، Ultralytics ، مهام الرؤية ، معالجة الصور ، تطبيقات صناعية ، تفاعل المستخدم

|

||||

---

|

||||

|

||||

# نموذج تجزئة أي شيء بسرعة عالية (FastSAM)

|

||||

|

||||

نموذج تجزئة أي شيء بسرعة عالية (FastSAM) هو حلاً مبتكرًا للعصب الشبكي يعمل بالزمن الحقيقي لمهمة تجزئة أي كائن داخل صورة ما. تم تصميم هذه المهمة لتجزئة أي كائن داخل صورة بناءً على إشارات تفاعل المستخدم المختلفة الممكنة. يقلل الـ FastSAM من الاحتياجات الحسابية بشكل كبير مع الحفاظ على أداء تنافسي ، مما يجعله خيارًا عمليًا لمجموعة متنوعة من مهام الرؤية.

|

||||

|

||||

|

||||

|

||||

## نظرة عامة

|

||||

|

||||

تم تصميم FastSAM للتغلب على القيود الموجودة في [نموذج تجزئة ما شيء (SAM)](sam.md) ، وهو نموذج تحويل ثقيل يتطلب موارد حسابية كبيرة. يفصل FastSAM عملية تجزئة أي شيء إلى مرحلتين متسلسلتين: تجزئة جميع الأمثلة واختيار موجه بناءً على التعليمات. تستخدم المرحلة الأولى [YOLOv8-seg](../tasks/segment.md) لإنتاج قناع التجزئة لجميع الأمثلة في الصورة. في المرحلة الثانية ، يتم إخراج منطقة الاهتمام المتعلقة بالتعليمة.

|

||||

|

||||

## المميزات الرئيسية

|

||||

|

||||

1. **حلاً في الوقت الحقيقي**: من خلال استغلال كفاءة الشبكات العصبية الحاسوبية ، يوفر FastSAM حلاً في الوقت الحقيقي لمهمة تجزئة أي شيء ، مما يجعله قيمًا للتطبيقات الصناعية التي تتطلب نتائج سريعة.

|

||||

|

||||

2. **كفاءة وأداء**: يقدم FastSAM تقليل كبير في الاحتياجات الحسابية واستخدام الموارد دون التنازل عن جودة الأداء. يحقق أداءً قابلاً للمقارنة مع SAM ولكن بموارد حسابية مخفضة بشكل كبير ، مما يمكن من تطبيقه في الوقت الحقيقي.

|

||||

|

||||

3. **تجزئة يستند إلى الموجه**: يمكن لـ FastSAM تجزئة أي كائن داخل صورة ترشده مختلف إشارات تفاعل المستخدم الممكنة ، مما يوفر مرونة وقابلية للتكيف في سيناريوهات مختلفة.

|

||||

|

||||

4. **يستند إلى YOLOv8-seg**: يستند FastSAM إلى [YOLOv8-seg](../tasks/segment.md) ، وهو كاشف كائنات مجهز بفرع تجزئة المثيلات. يمكنه بشكل فعال إنتاج قناع التجزئة لجميع الأمثلة في صورة.

|

||||

|

||||

5. **نتائج تنافسية في الاختبارات التحضيرية**: في مهمة اقتراح الكائن على MS COCO ، يحقق FastSAM درجات عالية بسرعة أسرع بكثير من [SAM](sam.md) على بطاقة NVIDIA RTX 3090 واحدة ، مما يدل على كفاءته وقدرته.

|

||||

|

||||

6. **تطبيقات عملية**: توفر الطريقة المقترحة حلاً جديدًا وعمليًا لعدد كبير من مهام الرؤية بسرعة عالية حقًا ، بمعدلات سرعة عشرات أو مئات المرات أسرع من الطرق الحالية.

|

||||

|

||||

7. **جدوى ضغط النموذج**: يظهر FastSAM إمكانية تقليل الجهد الحسابي بشكل كبير من خلال إدخال سابق اصطناعي للهيكل ، مما يفتح إمكانيات جديدة لهندسة هيكل النموذج الكبير لمهام الرؤية العامة.

|

||||

|

||||

## النماذج المتاحة ، المهام المدعومة ، وأوضاع التشغيل

|

||||

|

||||

يعرض هذا الجدول النماذج المتاحة مع أوزانها المحددة ، والمهام التي تدعمها ، ومدى توافقها مع أوضاع التشغيل المختلفة مثل [الاستنتاج](../modes/predict.md) ، [التحقق](../modes/val.md) ، [التدريب](../modes/train.md) ، و[التصدير](../modes/export.md) ، مشار إليها برموز الـ✅ للأوضاع المدعومة والرموز ❌ للأوضاع غير المدعومة.

|

||||

|

||||

| نوع النموذج | أوزان تم تدريبها مسبقًا | المهام المدعومة | الاستنتاج | التحقق | التدريب | التصدير |

|

||||

|-------------|-------------------------|---------------------------------------|-----------|--------|---------|---------|

|

||||

| FastSAM-s | `FastSAM-s.pt` | [تجزئة المثيلات](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||

| FastSAM-x | `FastSAM-x.pt` | [تجزئة المثيلات](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||

|

||||

## أمثلة الاستخدام

|

||||

|

||||

يسهل دمج نماذج FastSAM في تطبيقات Python الخاصة بك. يوفر Ultralytics واجهة برمجة تطبيقات Python سهلة الاستخدام وأوامر CLI لتسهيل التطوير.

|

||||

|

||||

### استخدام التوقعات

|

||||

|

||||

للقيام بكشف الكائنات في صورة ، استخدم طريقة `predict` كما هو موضح أدناه:

|

||||

|

||||

!!! Example "مثال"

|

||||

|

||||

=== "بايثون"

|

||||

```python

|

||||

from ultralytics import FastSAM

|

||||

from ultralytics.models.fastsam import FastSAMPrompt

|

||||

|

||||

# حدد مصدر التوقع

|

||||

source = 'path/to/bus.jpg'

|

||||

|

||||

# قم بإنشاء نموذج FastSAM

|

||||

model = FastSAM('FastSAM-s.pt') # or FastSAM-x.pt

|

||||

|

||||

# تنفيذ توقعات على صورة

|

||||

everything_results = model(source, device='cpu', retina_masks=True, imgsz=1024, conf=0.4, iou=0.9)

|

||||

|

||||

# قم بتجهيز كائن معالج مع قواعد التوقع

|

||||

prompt_process = FastSAMPrompt(source, everything_results, device='cpu')

|

||||

|

||||

# التوقع باستخدام كل شيء

|

||||

ann = prompt_process.everything_prompt()

|

||||

|

||||

# bbox الشكل الافتراضي [0،0،0،0] -> [x1،y1،x2،y2]

|

||||

ann = prompt_process.box_prompt(bbox=[200، 200، 300، 300])

|

||||

|

||||

# التوقع النصي

|

||||

ann = prompt_process.text_prompt(text='صورة لكلب')

|

||||

|

||||

# التوقع النقطي

|

||||

ann = prompt_process.point_prompt(points=[[200، 200]]، pointlabel=[1])

|

||||

prompt_process.plot(annotations=ann، output='./')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

```bash

|

||||

# قم بتحميل نموذج FastSAM وتجزئة كل شيء به

|

||||

yolo segment predict model=FastSAM-s.pt source=path/to/bus.jpg imgsz=640

|

||||

```

|

||||

|

||||

توضح هذه المقاطع البساطة في تحميل نموذج مدرب مسبقًا وتنفيذ توقع على صورة.

|

||||

|

||||

### استخدام مهام التحقق

|

||||

|

||||

يمكن تنفيذ التحقق من النموذج على مجموعة بيانات على النحو التالي:

|

||||

|

||||

!!! Example "مثال"

|

||||

|

||||

=== "بايثون"

|

||||

```python

|

||||

from ultralytics import FastSAM

|

||||

|

||||

# قم بإنشاء نموذج FastSAM

|

||||

model = FastSAM('FastSAM-s.pt') # or FastSAM-x.pt

|

||||

|

||||

# قم بتنفيذ التحقق من النموذج

|

||||

results = model.val(data='coco8-seg.yaml')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

```bash

|

||||

# قم بتحميل نموذج FastSAM وأجرِ التحقق منه بخصوص مجموعة البيانات مثال كوكو 8 بحجم صورة 640

|

||||

yolo segment val model=FastSAM-s.pt data=coco8.yaml imgsz=640

|

||||

```

|

||||

|

||||

يرجى ملاحظة أن الـ FastSAM يدعم فقط الكشف والتجزئة لفئة واحدة من الكائن. هذا يعني أنه سيتعرف ويجزء جميع الكائنات على أنها نفس الفئة. لذلك ، عند إعداد مجموعة البيانات ، يجب تحويل جميع معرفات فئة الكائن إلى 0.

|

||||

|

||||

## استخدام FastSAM الرسمي

|

||||

|

||||

يتوفر نموذج FastSAM مباشرةً من مستودع [https://github.com/CASIA-IVA-Lab/FastSAM](https://github.com/CASIA-IVA-Lab/FastSAM). فيما يلي نظرة عامة موجزة على الخطوات التقليدية التي قد تتخذها لاستخدام FastSAM:

|

||||

|

||||

### التثبيت

|

||||

|

||||

1. استنسخ مستودع FastSAM:

|

||||

```shell

|

||||

git clone https://github.com/CASIA-IVA-Lab/FastSAM.git

|

||||

```

|

||||

|

||||

2. أنشئ بيئة Conda وفعّلها بـ Python 3.9:

|

||||

```shell

|

||||

conda create -n FastSAM python=3.9

|

||||

conda activate FastSAM

|

||||

```

|

||||

|

||||

3. انتقل إلى المستودع المنسخ وقم بتثبيت الحزم المطلوبة:

|

||||

```shell

|

||||

cd FastSAM

|

||||

pip install -r requirements.txt

|

||||

```

|

||||

|

||||

4. قم بتثبيت نموذج CLIP:

|

||||

```shell

|

||||

pip install git+https://github.com/openai/CLIP.git

|

||||

```

|

||||

|

||||

### مثال الاستخدام

|

||||

|

||||

1. قم بتنزيل [تفويض نموذج](https://drive.google.com/file/d/1m1sjY4ihXBU1fZXdQ-Xdj-mDltW-2Rqv/view?usp=sharing).

|

||||

|

||||

2. استخدم FastSAM للتوقع. أمثلة الأوامر:

|

||||

|

||||

- تجزئة كل شيء في صورة:

|

||||

```shell

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg

|

||||

```

|

||||

|

||||

- تجزئة كائنات محددة باستخدام تعليمات النص:

|

||||

```shell

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --text_prompt "الكلب الأصفر"

|

||||

```

|

||||

|

||||

- تجزئة كائنات داخل مربع محدد (تقديم إحداثيات الصندوق في تنسيق xywh):

|

||||

```shell

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --box_prompt "[570,200,230,400]"

|

||||

```

|

||||

|

||||

- تجزئة كائنات قرب النقاط المحددة:

|

||||

```shell

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --point_prompt "[[520,360],[620,300]]" --point_label "[1,0]"

|

||||

```

|

||||

|

||||

بالإضافة إلى ذلك ، يمكنك تجربة FastSAM من خلال [Colab demo](https://colab.research.google.com/drive/1oX14f6IneGGw612WgVlAiy91UHwFAvr9?usp=sharing) أو على [HuggingFace web demo](https://huggingface.co/spaces/An-619/FastSAM) لتجربة بصرية.

|

||||

|

||||

## الاقتباسات والشكر

|

||||

|

||||

نود أن نشكر أباء FastSAM على مساهماتهم الهامة في مجال تجزئة المثيلات في الوقت الحقيقي:

|

||||

|

||||

!!! Quote ""

|

||||

|

||||

=== "بيب تيكس"

|

||||

|

||||

```bibtex

|

||||

@misc{zhao2023fast,

|

||||

title={Fast Segment Anything},

|

||||

author={Xu Zhao and Wenchao Ding and Yongqi An and Yinglong Du and Tao Yu and Min Li and Ming Tang and Jinqiao Wang},

|

||||

year={2023},

|

||||

eprint={2306.12156},

|

||||

archivePrefix={arXiv},

|

||||

primaryClass={cs.CV}

|

||||

}

|

||||

```

|

||||

|

||||

يمكن العثور على ورقة FastSAM الأصلية على [arXiv](https://arxiv.org/abs/2306.12156). قام الأباء بجعل أعمالهم متاحة للجمهور ، ويمكن الوصول إلى قاعدة الكود على [GitHub](https://github.com/CASIA-IVA-Lab/FastSAM). نقدر جهودهم في تطوير المجال وجعل أعمالهم متاحة للمجتمع الأوسع.

|

||||

|

|

@ -1,98 +0,0 @@

|

|||

---

|

||||

comments: true

|

||||

description: استكشف مجموعة متنوعة من عائلة YOLO، ونماذج SAM وMobileSAM وFastSAM وYOLO-NAS وRT-DETR المدعومة من Ultralytics. ابدأ بأمثلة لكل من استخدام واجهة الأوامر وPython.

|

||||

keywords: Ultralytics, documentation, YOLO, SAM, MobileSAM, FastSAM, YOLO-NAS, RT-DETR, models, architectures, Python, CLI

|

||||

---

|

||||

|

||||

# النماذج المدعومة من Ultralytics

|

||||

|

||||

أهلاً بك في وثائق نماذج Ultralytics! نحن نقدم الدعم لمجموعة واسعة من النماذج، كل منها مُصمم لمهام محددة مثل [الكشف عن الأجسام](../tasks/detect.md)، [تقطيع الحالات](../tasks/segment.md)، [تصنيف الصور](../tasks/classify.md)، [تقدير الوضعيات](../tasks/pose.md)، و[تتبع الأجسام المتعددة](../modes/track.md). إذا كنت مهتمًا بالمساهمة في هندسة نموذجك مع Ultralytics، راجع دليل [المساهمة](../../help/contributing.md).

|

||||

|

||||

!!! Note "ملاحظة"

|

||||

|

||||

🚧 تحت الإنشاء: وثائقنا بلغات متعددة قيد الإنشاء حاليًا، ونحن نعمل بجد لتحسينها. شكرًا لصبرك! 🙏

|

||||

|

||||

## النماذج المميزة

|

||||

|

||||

إليك بعض النماذج الرئيسية المدعومة:

|

||||

|

||||

1. **[YOLOv3](yolov3.md)**: الإصدار الثالث من عائلة نموذج YOLO، الذي أنشأه أصلاً Joseph Redmon، والمعروف بقدراته الفعالة في الكشف عن الأجسام في الوقت الفعلي.

|

||||

2. **[YOLOv4](yolov4.md)**: تحديث محلي لـ YOLOv3، تم إصداره بواسطة Alexey Bochkovskiy في 2020.

|

||||

3. **[YOLOv5](yolov5.md)**: نسخة مُحسنة من هندسة YOLO من قبل Ultralytics، توفر أداءً أفضل وتوازن في السرعة مقارنة بالإصدارات السابقة.

|

||||

4. **[YOLOv6](yolov6.md)**: أُصدرت بواسطة [Meituan](https://about.meituan.com/) في 2022، ويُستخدم في العديد من روبوتات التوصيل الذاتية للشركة.

|

||||

5. **[YOLOv7](yolov7.md)**: تم إصدار نماذج YOLO المحدثة في 2022 بواسطة مؤلفي YOLOv4.

|

||||

6. **[YOLOv8](yolov8.md) جديد 🚀**: الإصدار الأحدث من عائلة YOLO، يتميز بقدرات مُعززة مثل تقطيع الحالات، تقدير الوضعيات/النقاط الرئيسية، والتصنيف.

|

||||

7. **[Segment Anything Model (SAM)](sam.md)**: نموذج Segment Anything Model (SAM) من Meta.

|

||||

8. **[Mobile Segment Anything Model (MobileSAM)](mobile-sam.md)**: نموذج MobileSAM للتطبيقات المحمولة، من جامعة Kyung Hee.

|

||||

9. **[Fast Segment Anything Model (FastSAM)](fast-sam.md)**: نموذج FastSAM من مجموعة تحليل الصور والفيديو، والمعهد الصيني للأتمتة، وأكاديمية العلوم الصينية.

|

||||

10. **[YOLO-NAS](yolo-nas.md)**: نماذج YOLO Neural Architecture Search (NAS).

|

||||

11. **[Realtime Detection Transformers (RT-DETR)](rtdetr.md)**: نماذج Realtime Detection Transformer (RT-DETR) من PaddlePaddle التابعة لشركة Baidu.

|

||||

|

||||

<p align="center">

|

||||

<br>

|

||||

<iframe width="720" height="405" src="https://www.youtube.com/embed/MWq1UxqTClU?si=nHAW-lYDzrz68jR0"

|

||||

title="مشغل فيديو YouTube" frameborder="0"

|

||||

allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture; web-share"

|

||||

allowfullscreen>

|

||||

</iframe>

|

||||

<br>

|

||||

<strong>شاهد:</strong> تشغيل نماذج YOLO من Ultralytics في بضعة أسطر من الكود فقط.

|

||||

</p>

|

||||

|

||||

## البدء في الاستخدام: أمثلة على الاستخدام

|

||||

|

||||

يوفر هذا المثال أمثلة مبسطة على التدريب والاستدلال باستخدام YOLO. للحصول على الوثائق الكاملة عن هذه وغيرها من [الأوضاع](../modes/index.md), انظر صفحات وثائق [التنبؤ](../modes/predict.md)، و[التدريب](../modes/train.md)، و[التقييم](../modes/val.md) و[التصدير](../modes/export.md).

|

||||

|

||||

لاحظ أن المثال أدناه هو لنماذج [Detect](../tasks/detect.md) YOLOv8 لكشف الأجسام. للاطلاع على المهام الإضافية المدعومة، راجع وثائق [Segment](../tasks/segment.md)، و[Classify](../tasks/classify.md) و[Pose](../tasks/pose.md).

|

||||

|

||||

!!! Example "مثال"

|

||||

|

||||

=== "Python"

|

||||

|

||||

نماذج `*.pt` المُدربة مسبقًا وملفات الإعداد `*.yaml` يمكن أن تُمرر إلى فئات `YOLO()`, `SAM()`, `NAS()` و `RTDETR()` لإنشاء مثال نموذج في Python:

|

||||

|

||||

```python

|

||||

من ultralytics استيراد YOLO

|

||||

|

||||

# تحميل نموذج YOLOv8n المُدرب مسبقًا على COCO

|

||||

النموذج = YOLO('yolov8n.pt')

|

||||

|

||||

# عرض معلومات النموذج (اختياري)

|

||||

model.info()

|

||||

|

||||

# تدريب النموذج على مجموعة البيانات المثالية COCO8 لمدة 100 عصر

|

||||

النتائج = model.train(data='coco8.yaml', epochs=100, imgsz=640)

|

||||

|

||||

# تشغيل الاستدلال بنموذج YOLOv8n على صورة 'bus.jpg'

|

||||

النتائج = model('path/to/bus.jpg')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

|

||||

الأوامر CLI متاحة لتشغيل النماذج مباشرة:

|

||||

|

||||

```bash

|

||||

# تحميل نموذج YOLOv8n المُدرب مسبقًا على COCO وتدريبه على مجموعة البيانات المثالية COCO8 لمدة 100 عصر

|

||||

yolo train model=yolov8n.pt data=coco8.yaml epochs=100 imgsz=640

|

||||

|

||||

# تحميل نموذج YOLOv8n المُدرب مسبقًا على COCO وتشغيل الاستدلال على صورة 'bus.jpg'

|

||||

yolo predict model=yolov8n.pt source=path/to/bus.jpg

|

||||

```

|

||||

|

||||

## المساهمة بنماذج جديدة

|

||||

|

||||

هل أنت مهتم بالمساهمة بنموذجك في Ultralytics؟ رائع! نحن دائمًا منفتحون على توسيع محفظة النماذج لدينا.

|

||||

|

||||

1. **احفظ نسخة عن المستودع**: ابدأ بحفظ نسخة عن [مستودع Ultralytics على GitHub](https://github.com/ultralytics/ultralytics).

|

||||

|

||||